市場調査やデスクリサーチを爆速で仕上げる生成AIツールの使い方

最近、委託業務として、マーケティングに関する市場調査や新規事業に関するデスクリサーチを仕事として、よく行っています。その際に、生成AIが流行った今だと、従来型のGoogleによる検索の面倒臭さが非常に目立つため、生成AIツールを業務に活用しています。

しかし、既存の生成AIツールでも、まだまだ改善の余地があるため、現在はDeskRexという生成AIデスクリサーチツールを開発しています。ぜひ登録してみて下さい。

今回は、市場調査やデスクリサーチに使える生成AIツールをご紹介し、私の使い方をシェアしますので、みなさんのリサーチにぜひ役立ててもらえればと思います。

デスクリサーチの課題とAIの解決策

デスクリサーチは様々な目的で行われることがあります。私の場合は、起業のアイデア、新規事業の競合の調査、海外のイノベーションのトレンドの調査などをご依頼いただくことが多いですし、自分もそういう目的が多いです。また、人によっては、マーケティングのために、対象市場の基礎的な概観を調べたり、投資のためのデュー・デリジェンスのために3C分析を行うこともあります。

これらの作業は実に労働集約的で、結果的に得られる知識は面白いものですが、過程は非常に大変です。これらの個々の課題を生成AIでどう改善できるのか?ということになります。

デスクリサーチの課題

デスクリサーチには多くの課題がありますが、AIの力を借りることで、これらの課題を克服することが可能です。具体的には、以下のような点でAIが有用です。

- そもそも検索がめんどくさい

- 検索キーワードを試行錯誤するのがめんどくさい。

- 言語的に、海外の文献を調べるのが難しい。

- 集めた情報から有益なデータを抽出するのが面倒くさい

- 要約を作るため、目を通す作業がしんどい

- MECEに情報を集約できているか、調べ漏れがないかを確認するのが大変

- 集めた情報をきれいにまとめるのがめんどくさい

- チームに共有するために、見やすくするのが時間かかる

- 出典をしっかり揃えることがめんどくさい。

などなど、かなり労働集約的なんですよね。他方で、特許や企業検索など、一定の有料データベースサービスを使うことでこの作業をスキップできる部分もありますが、予算や情報の幅広さの兼ね合いもあるため、完全に回避はできないでしょう。

生成AIによるデスクリサーチの効率化

これらの労働集約的な課題に対して、生成AIを使うと下記のことを効率化できます。

- キーワードの自動生成

- 英語の翻訳

- 関連する情報の抽出

- 大量のテキストデータからの要点の抽出

- レポートの整形

ただ、Chat GPTなどの生成AIツールはデスクリサーチに特化しているわけではないので、使うのに工夫や慣れが必要であるため、上記のことができても、広まらないよな、とは思います。

そういう意味では、生成AIツールを使って、慣れてでも、労働集約的なデスクリサーチや市場調査業務をなくしたい人だけが、いまは仕事を楽にできるのかもしれません。ITリテラシーも一定必要なのか辛いところです。

実用性の高い生成AIツールとデスクリサーチでの使い方

デスクリサーチに活用できるAIツールは多数ありますが、それぞれに長所と短所があります。以下に、私が実用している主要なツールをいくつか紹介します。

有料版のChatGPT

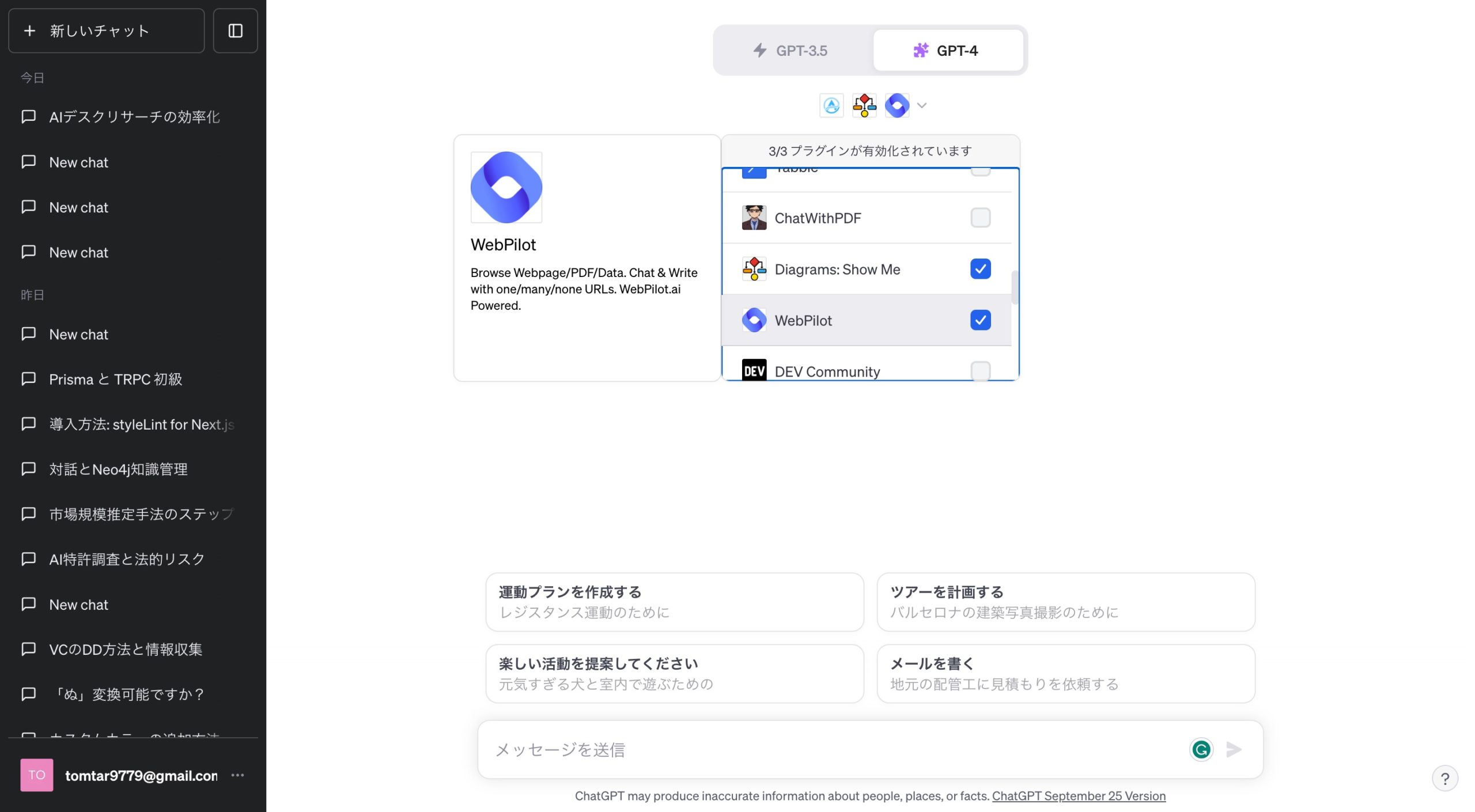

ChatGPTは大規模言語モデルの生成AIツールです。基本的な使い方は、AIが学習済みのデータに基づいてディスカッションしたり、相談したりという使い方があります。他方で、有料版では、ウェブに接続できるようなPluginやBing検索などが使えるので、私はそれを使っています。

私の実際の使い方は下記のとおりです。

- Webpilotというプラグインを導入する。

- Webpilotはプログラミングライブラリの定義に基づいて、一定のユーザーの検索意図からクエリを推定し、ウェブページを引っ張ってきてくれる。

- BingAIの場合も同様だが、プロンプトで細かく指定するのは難しいため、単発の検索ではいいが、色々な領域を深ぼる時ににはおすすめできない。

- 「〇〇の市場について、複数ソースから英語で検索して要約してまとめてください。出典を明記してください。」などのプロンプトを投げて、調査結果を確認していく。

- プロンプトによっては、見つからないなど嘘をつくこともある。

- この場合は、しょうがないので、自分でGoogleでクエリを投げるしか無い。

- プロンプトによっては、見つからないなど嘘をつくこともある。

- 必要に応じて、Doc Maker A+で文書を作成したり、Diagrams Show Meでグラフを作成していい感じにレポートにしていく。

- Chat GPTはトークン量の制限があるため、長文のレポートをまとめるのは難しい。

- そのため、まとめる際には調査したセクションごとに整形の依頼をするしかない。

- Chat GPTはトークン量の制限があるため、長文のレポートをまとめるのは難しい。

色々と文句はありつつも、Googleだけで検索するよりかは、プロンプトの工夫次第で業務を効率化できるのがポイントです。

- 長所: 検索、要約、整形など、様々な業務に対応できる。

- 短所: 20ドル支払う必要あり、プロンプトの自由度が高すぎ、プラグインの挙動に結果が左右される

PerplexityAI

PerplexityAIは無料で使うこともできる「検索」に特化した生成AIツールです。直近では、5億ドルの投資も受けているイケイケスタートアップですね。

使ってみるとわかるんですが、検索用です。検索に特化しているので、”単発”で特定のテーマを調べることに向いています。検索をまたいだ記憶は難しいですし、複雑なプロンプトには対応できません。

しかし、無料で無限に使えるのと、数時間に5回までは精度を高めた検索機能を使えます。特徴は下記のように、複数のソースを瞬時に出して、要約します。おそらく、Googleの結果から該当しそうなページを上から出しています。ゆえに、Webpilotよりも直感的に検索できますが、長い指示や整形や推定などができないのがデメリットです。

私の実際の使い方は下記のとおりです。

- 事前に検討した調査項目をPerplexityに入れる。

- 要約にざっくり目を通し、興味があるソースをクリックする。

- 検索結果のソースも目視で確認する。

- 個別のソースの深掘りはプロンプトを工夫しないとできないので、面倒だが仕方ない。

- また別の調査項目を入れる。

- 以下繰り返し。。。

有料版を使ったこともありますが、正直、無料版で検索の完成度高いので、あまり必要性を感じませんでした。GPT4とClaudeによる対話型検索ができますが、検索の要件が定義できてない場合は色々サポートしてもらえるのでいいかもしれません。

- 長所: 無料でも便利、検索に特化しているので使い方が簡単

- 短所: 形容詞の解釈などを間違える、言語指定を間違えるなど複雑なプロンプトはちょっと苦手

ChatPDF

ChatPDFは、調べたい情報がPDFのときに便利で、PDFのテキストデータをベクター化したものを対話型に聞くことができます。GPT3.5なので、あんまり会話の精度は高くありませんが、有料版で4に変えることもできますが、無料でも一つのPDFを深掘りするにはありかなという感じのものです。

私の実際の使い方は下記のとおりです。

- 検索結果のPDFをアップロードする

- 調査の目的に必要な質問事項をインプットしていく。

- 質問ごとに出典を明記してもらえるので、そこをメモしてレポートに入れていく。

- 調査の目的に必要な質問事項をインプットしていく。

- また別の質問を入れる。

- 以下繰り返し。。。

有料版を使ったこともありますが、正直、無料版で検索の完成度高いので、あまり必要性を感じませんでした。GPT4とClaudeによる対話型検索ができますが、検索の要件が定義できてない場合は色々サポートしてもらえるのでいいかもしれません。

- 長所: 長いPDFでも処理できる、出典明記されている

- 短所: 無料だとPDFの数が限られる、対話の精度が高くない、デフォルトの質問が弱い

Claude2

Claude2は、ChatGPTの長文対応版だと思っていただければよいです。PDFや長文のテキストの整形や要約に使えます。長い文章をどうにかしたいときには、おすすめですが、GPT4ほどの理解力はないので、注意が必要です。また、検索などのプラグインもいまのところはありません。おそらく。

有料版はまだ使ったことありませんが、制限が来てしまうので、使ってみてハマったら有料にしてみようと思います。まだそこまで頻度はありませんが、長文では便利です。

- 長所: 無料、長いPDFやテキストを処理できる

- 短所: 4ほど賢くない、制限あり、検索などはできない

生成AIツールの使用上の注意点

AIツールを使用する際には、いくつかの注意点があります。特に、プロンプトの設定が重要です。AIは指示が明確でないと、期待する結果を得られない可能性があります。

- 明確なプロンプトの設定

- 継続的なモニタリングと調整

- AIの限界を理解する

自分の中で有用だなと思われるプロンプトをストックしておき、すぐにコピペできるようにすることが効率化への近道でしょう。

もし使い方で質問があればお気軽に聞いてください。実際に使っている動画を出しても面白いかもしれません。

リサーチツールをコーディングするという選択肢

また、もしあなたがプログラマーであれば、いくつかのオープンソースのリサーチツールが存在します。これらをカスタマイズしてもいいかもしれませんが、カスタマイズしなければそこまでいいものでないのが実情です。

https://github.com/search?q=scraping langchain&type=repositories

あとは、Langchainで自前で実装するのもいいと思います。関数が豊富です。

冒頭でも述べましたが、既存の生成AIツールは、まだまだ改善の余地があるため、現在はDeskRexという生成AIデスクリサーチツールを開発しています。今のツールに不満を持ったらぜひ登録してみて下さい!

コメント