大規模行動モデル(LAM)がもらたす次世代自律型インターフェース

RabbitとLAM(大規模行動モデル)

最新、AI企業であるRabbit社が開発したLarge Action Model(LAM)に注目が集まっています。LAMは、AI-firstハードウェアであるRabbit社のR1に組み込まれている大規模な行動モデルを特徴としています。

($199で販売)

生成AIはGPTを代表に言語モデルが現在ユーザーに普及していますが、GPT-4がマルチモーダルに画像を処理できるようになったことからわかるように、テキスト以外のインプットを中心とした発展が行われることは明らかです。

下記のサムアルトマンとビル・ゲイツの対談でも、GPT-5についての言及がされており、マルチモーダルについての汎用性の向上が触れられています。

- Multimodality: GPT-5 is poised to process and generate diverse data formats, including text, speech, images, and video, enhancing its versatility.

- Reasoning and Reliability: Altman emphasizes boosting reasoning abilities in GPT-5, ensuring more reliable outputs for enhanced real-world applications.

- Customizability and Personalization: GPT-5 aims to offer user customization, adapting to individual preferences, and expanding its utility across a spectrum of tasks.

- Integration with Personal Data: GPT-5 will seamlessly integrate personal data, such as email and calendar, for a more personalized and relevant AI experience.

- Video Capabilities: Altman’s insights reveal that video capabilities will be a major feature, underlining the importance of a comprehensive multimedia approach.

そこで、Rabbit社のLarge Action Model(LAM)は、Neuro-SymbolicアプローチとAIハードウェアを組み合わせて、ユーザーに革新的なAI体験を提供することを目指しています。

R1は、SpotifyやUberなどのアプリとのやり取りデータで訓練されたLarge Action Model(LAM)によって動作し、柔軟で適応性のあるAIアシスタントを実現します。また、R1は、特別なトレーニングモードを備えており、ユーザーがデバイスに特定のアクションを教えることができます。

*RabbitのウェブサイトのResearchページには、AirBnBでの部屋の予約を行うユーザーのデモがあります。

このデモでは、LAMがユーザーと同じアクションを取るのを見ることができます。Rabbitチームは、LLMが生のHTMLを使用してアプリケーションを理解することの難しさについて言及しています。

Rabbit R1は、専用のLLMエージェントデバイスとしてCESで発表され、Teach Modeを使用してAIに行動を教える能力を持っています。また、LAMはユーザーの意図を行動に変換するための基本モデルとして使用されており、実験的な「teach mode」を使用して、Midjourneyを介して画像を生成するAIも見られました。

また、彼らは「teach mode」がHTMLを使用しないモバイルおよびデスクトップアプリケーションでも機能すると主張しています。Rabbitは、階層的ポリシーを使用して、高レベルの指示と低レベルのコマンドを統合する方法について言及しています。Rabbitは、ソフトウェアアプリケーション内のタスクの検出と実行の問題を複数の段階に分け、それぞれにカスタマイズされたモデルを使用することができると述べています。

つまりユーザーのテキストではなく、行動をインプットデータとして学習していくということで、少し前だとRPAのようなイメージでしょうか。

私はRPAのサービスをあんまり使ったことがありませんが、ユーザーの行動をの記録と再現と応用が今後、スマートフォンはもちろん様々なデバイスに組み込まれるのかもしれないということです。

ちなみに、Rabbit社のCEOであるJesse Lyuによると、R1のビジョンは、音声アシスタント、スクリーン、カメラの組み合わせであり、R1は、iPhoneではなく、Humaneの新しいAI Pinなどのデバイスと競合する可能性が高いと述べています。

自律型エージェントとしてのLAM

行動だけではなく、LLMのイノベーションでは、大規模な言語モデルが「エージェント」として拡張されるという新しいトレンドが現れています。

これにより、言語モデルの流暢さと独立したタスクの実行能力を組み合わせることで、生成的AIは受動的なツールから、リアルタイムで作業を行う能動的なパートナーに昇華されます。

たしかにLLMの可能性はテキストだけではなく、Actionに拡張すれば、さらにプロアクティブにAIがアクションを起こすことが可能になる可能性があります。

LAMは、組み合わせ的なタスクの膨大さとそれと組み合わせるインターフェースの多様さから非常に難しいとされていますが、Hierarchical Policies for Web Actions using LLM (HeaP) のような研究も出てきています。

LLMでサブタスクを分解して、Webの操作のタスクに取り組むようです。

ちなみに、下記のアクセンチュアのNayan Paul氏の記事ではLAMについて触れたものではないですが、LLMが顧客のために次の推奨アクションを理解して、提案する未来に触れています。

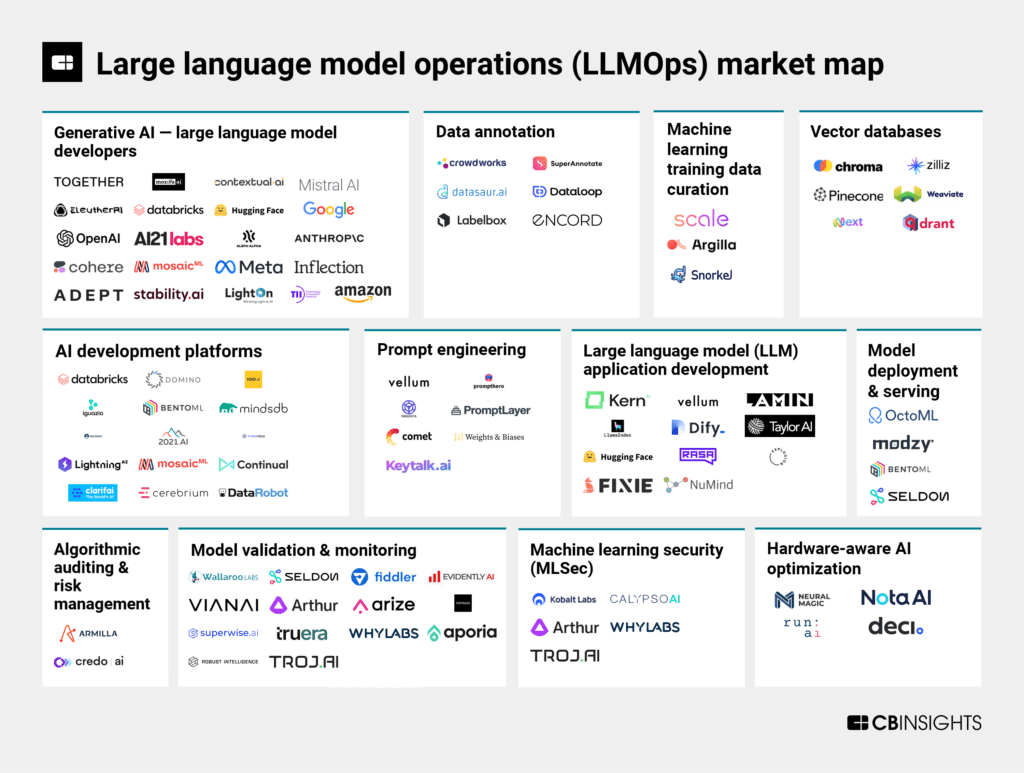

テックスタックとしては、ベクターDBとGPTのFunctional Callingですが、LAMのような独自のモデルが普及したり公開されたりすることで、デバイスの自律性がさらに高まることは容易に想像がつきます。

- They get 3 primary types of asks from customers. Firstly, they might get a complaint, defect log or delays in shipping etc. So the ask is to find out a way to provide some resolution and then guide the user to follow up with a “next best action” — like system will raise a refund ticket for him directly.

- Second is where the customers are asking about/ enquiring about a new process/ product etc. In that case the “next best action” is more about providing the information and suggesting what is next — for example it can be to automatically place an order for that new item for the customer.

- Third, the ask can be to help with some existing status/ order update etc. In this case as well, the system can enquire about the order directly and based on customers history suggest new follow ups.

- There can be other similer usages of “next best action”. The goal is to provide a technical solution that can scale and adjust easily.

「LAMは、LLMの言語的能力を維持するだけでなく、より高度な認知機能への重要なステップであり、マルチホップ思考、複雑な推論、行動にも優れているため、機能的言語能力と形式的言語能力の両方に合致している。」と比較がなされています。

Large Language Models (LLMs) vs Large Agentic Models (LAMs)

LLMs so far have demonstrated exceptional proficiency in formal linguistic competence, excelling in tasks that involve language understanding, general reasoning and generation.

However, the capabilities in functional… pic.twitter.com/LMpcxDhonH

— SuperAGI (@_superAGI) November 15, 2023

ちなみに、Adeptというスタートアップは、WebページのUI要素のアクションスペース内でアクションを起こすためのモデルであるAction Transformer(ACT-1)を開発しています。Adeptは、広範な基盤モデルを構築し、非常に大きな「アクションスペース」を持つことを目指しています。

他にも、例えば、GlyphicはB2Bセールスのアクションスペース内でアクションを起こすための製品を構築し、ShiftLabはeコマースのアクションスペース内でアクションを起こすための製品を構築し、Harveyは弁護士のアクションスペースのために製品を構築しています。

パーソナルコンピューターからスマートフォンまで、デバイスに埋め込まれたアクションモデルがますます既存のユーザーインターフェースを無視する世界観が今後数年に訪れる可能性は高いのでしょう。

ちなみに、SalaseForceは自社のブログでもLAMについて触れており、自社のプロダクトの入力の面倒さを十分に自覚していることがわかります。入力や管理を行うSaaSにおいては、LAMの研究を行うことがUX向上に寄与することが自明なのでしょう。

(ブログ記事よりLAMのある組織についてのGoogle翻訳)

- エージェントは Zoom で顧客と会い、ニーズ、アイデア、考えられる次のステップについて話し合います。

- 通話の記録は自動的に記録され、他の関連する CRM 情報とともに整理されます。

- 通話後、LAM はトランスクリプトを確認し、最も重要な瞬間を要約し、後で簡単に確認できるように結果をエージェントに送信します。

- さらに、LAM は、通話で言及された追加情報を提供するなど、実行する価値のある次のステップを特定します。この理解は、フォローアップ電子メールの下書きを自動的に作成するために使用され、その後、添付ファイルとして含まれる可能性のある関連文書を会社の資料から検索します。その後、エージェントには次のステップを実行する準備ができていることが通知され、実行前に最終確認と簡単な校正が可能になります。

- 最後に、LAM は代理店のプロセスを理解しているため、以前の顧客の決定に基づいたアップセルの機会であっても、会話を進めるために自動的に提案された議題を伴うその後の会議であっても、代理店の生産性と集中力を維持するためのさらなるステップを提案することができます。

- その過程で、LAM は、他の利害関係者を巻き込む必要がある可能性がある兆候に注意を払う場合があります。たとえば、不満やためらいの兆候を示している顧客は、「危険にさらされている」アカウントとみなされ、顧客に紹介される可能性があります。特に満足度の維持に重点を置いたサービススペシャリスト。

私達が多く使っているOpen AI自体もエージェントの構築は必ず機能として実装されるため、ファウンデーションモデルやアプリケーションと組み合わせたエッジケースをいかに社会実装していくか、重要な戦略観になるでしょう。

良くも悪くも耳目を集めるハードウェアのユースケースが今年は増えるかもしれません。

参考文献

この記事はDeskrexでリサーチした結果を参考に書いています。無料トライアルで使いたい方はこちら → https://lp.deskrex.ai/

コメント